🚨 如何用Veo 3制作更长的视频:

Justine Moore(a16z合伙人)花了几个小时实验新的图像到视频模式。

她发现了一种方法,可以生成一致且连贯的故事,比8秒的限制要长得多。

教程和技巧👇原文 https://t.co/LljG8jAwmS

首先:Veo 3仍然每次只能生成8秒的视频。

但你可以通过将一个片段的结尾帧作为下一个片段的起始帧来“延长”这个时间。

这听起来很简单,但实际上有点挑剔。这个经验为了让你避免浪费积分。

https://t.co/khTLNcqu5y

(1) 记住,最后一个片段的结尾帧是模型唯一的上下文。

因此,任何你希望之后再次出现的角色、物体或环境都必须出现在那个帧中。

例如,如果想让女人出现在下一个场景中,这个片段就不起作用。

https://t.co/GlfbbcQhA1

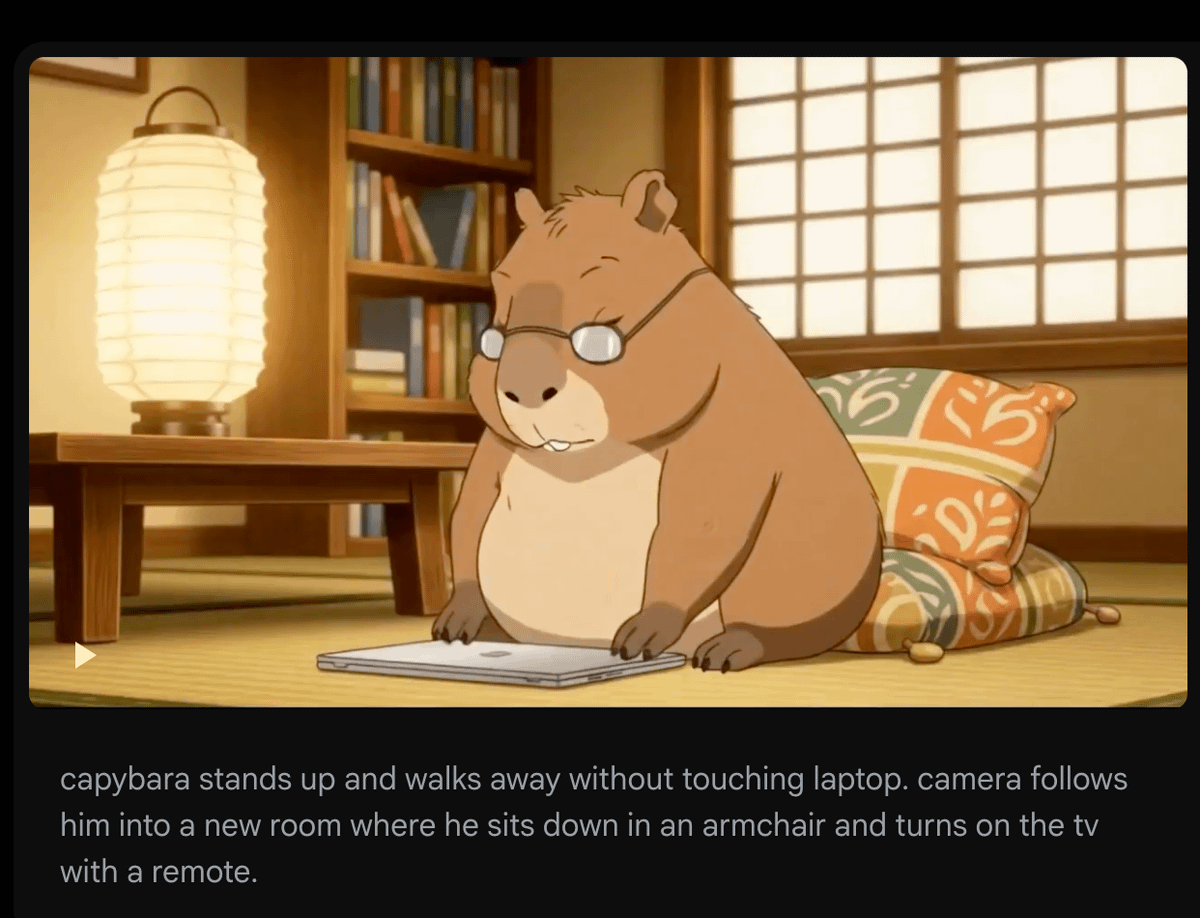

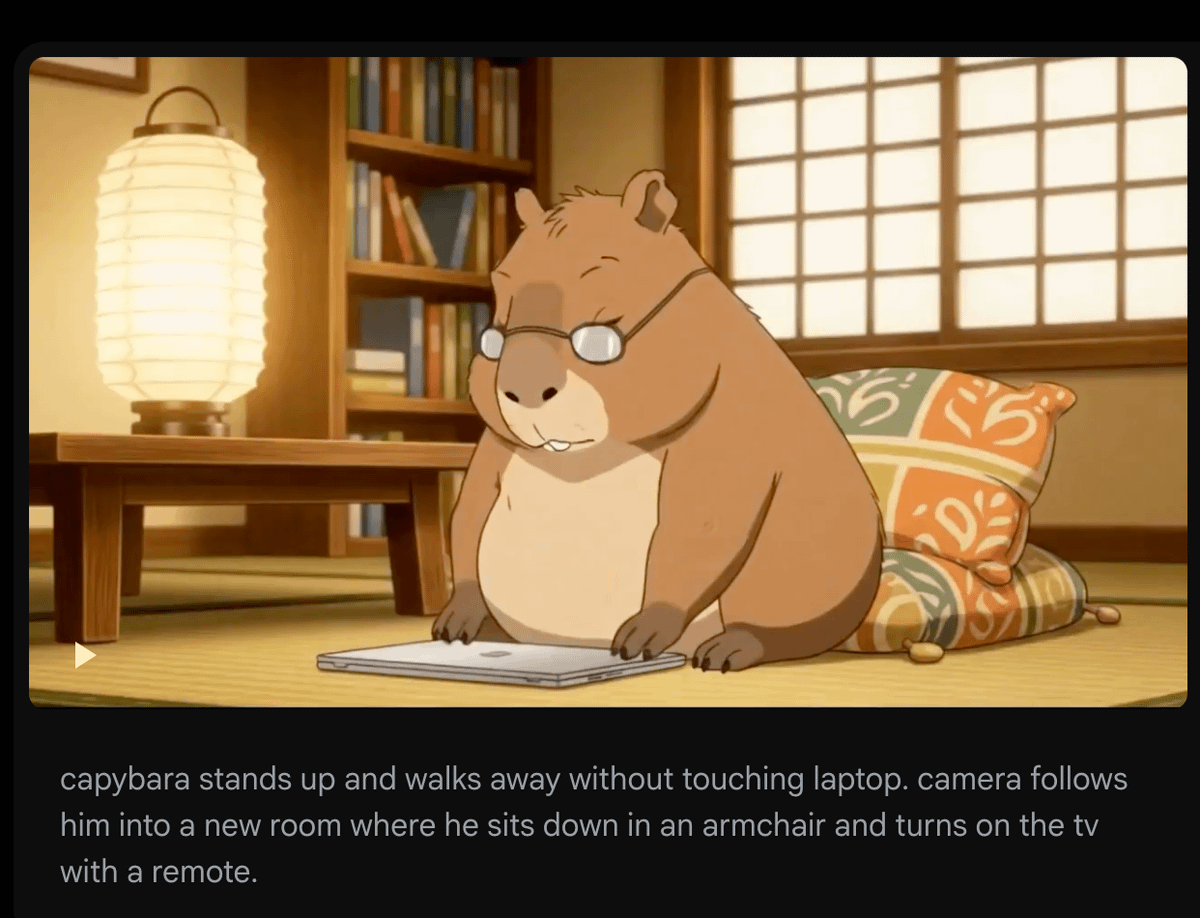

(2) 要知道,模型将使用图像中出现的内容来驱动未来的动作。

有时候,这会超过你的文本提示。

例如:一个关于水豚关掉电脑的片段。用结尾帧(在这里)来驱动下一个片段,在那个片段中我希望它起身走开。

这里明确地提示了超过10次。但因为它的爪子在电脑上,模型每次都会让它重新打开电脑! https://t.co/M85KJiU4pZ

(3) 你不能上传自己的音频,所以无法在多个片段中保持一致的角色声音。

有时通过提示特征(如口音、年龄、语调)会起作用。但并不完美——下面听一下同一个人跨两个片段的对话。

要解决这个问题,你可以选择:

1.) 在ElevenLabs上生成一致声音的片段,并用它们作为配音(将Veo视频中人物说话的部分静音)

2.) 直接使用Hedra,它让这个过程更容易!

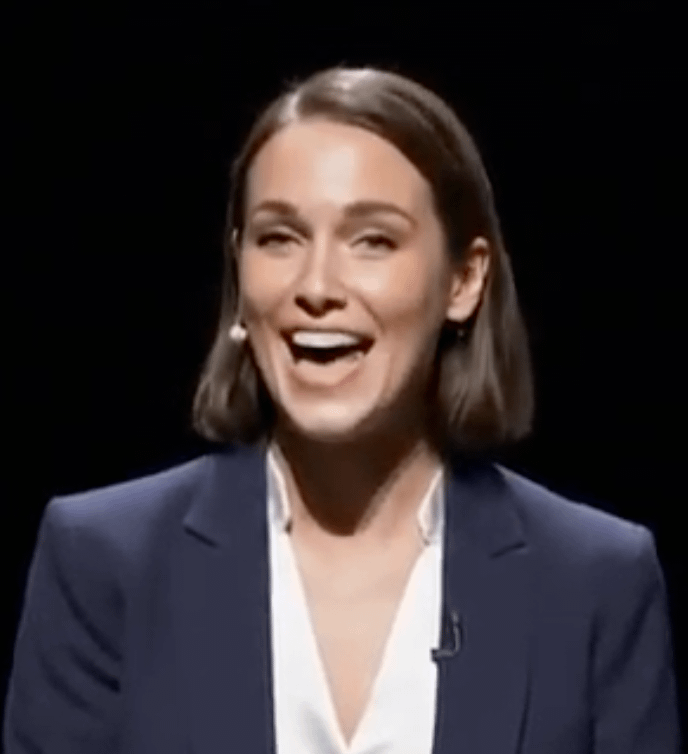

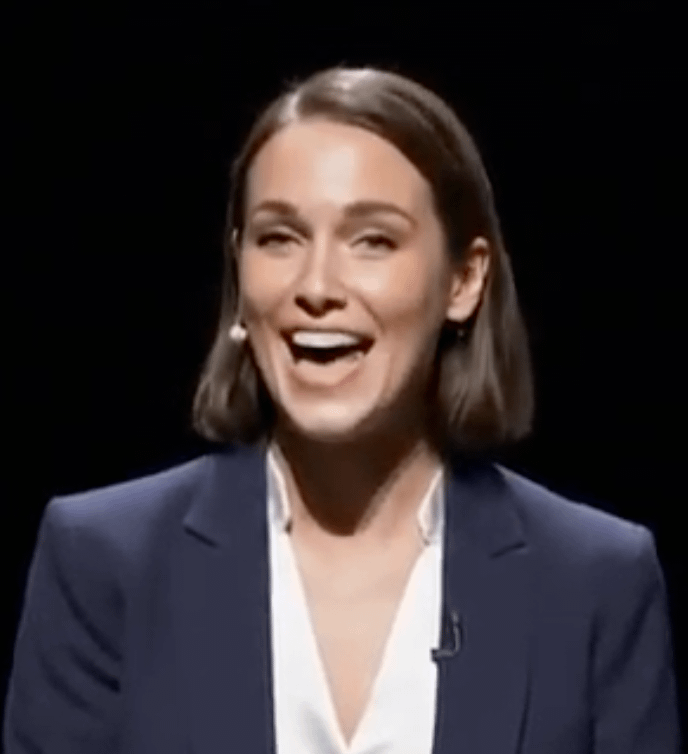

(4) 在不同环境中放置相同角色时并不完美。

如果你想改变服装或场景,但保持角色一致性,推荐先使用Flux Kontext编辑图像。

在这种情况下,这里上传了角色的照片,并要求Kontext把她放在舞台上穿着专业服装。然后将输出结果作为在Veo 3上的新起始帧。

https://t.co/A4SggcQsYF

(5) 细节在多次迭代中有时会退化。

比较一下第一个视频中女性发言者的脸部(在第一个片段)和第5个片段中的脸部。就像打电话传话一样——细节每次都会变化,而且这些变化会累积。

还没有找到解决办法。幸运的是,我们对非自己脸部的变化不那么敏感 😂 https://t.co/tOnbpOi4gc